La crise du Covid-19 a secoué la France ces derniers mois et se poursuit encore dans de nombreux pays. De très nombreuses applications d’intelligence artificielle ont été créées, que ce soit pour la prévision de la propagation de l’épidémie, l’aide au diagnostic médical, la recherche de remèdes ou pour veiller au respect de la distanciation physique. Mais l’IA a-t-elle vraiment convaincu ?

L’apprentissage statistique (machine learning) est, à l’heure actuelle, l’une des principales disciplines scientifiques dont la mise en œuvre fait fonctionner les systèmes d’intelligence artificielle. A l’interface entre mathématiques, statistiques et informatique, l’apprentissage statistique repose sur le traitement et l’analyse de grandes masses de données (big data). Ses performances dans certains domaines sont remarquables, l’analyse des images en particulier donne de très bons résultats que l’on apprécie par exemple en imagerie médicale.

Grands volumes de données versus situations inédites

La performance des algorithmes d’apprentissage statistique repose sur la disponibilité d’une grande quantité d’information destinée à leur entraînement. Or c’est précisément ce qui a manqué avec le Covid-19 : la situation étant inédite à l’ère de la société de l’information, il y avait trop peu d’images radiologiques de poumons malades à présenter aux algorithmes pour générer un diagnostic.

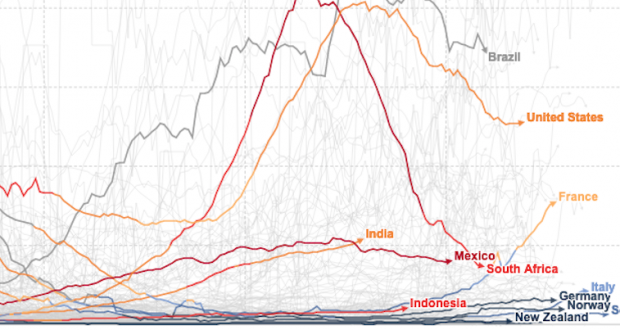

En quelques semaines, la déferlante de l’épidémie a fait s’effondrer tous les modèles établis : déplacements des populations, consommation des ménages, prix des matières premières… Sans précédent similaire sur lequel s’appuyer, les projections statistiques n’ont plus eu de sens. Les données ont donc nécessité des traitements manuels effectués par des humains afin de pouvoir continuer à alimenter les systèmes d’IA.

Comme le rappelle Jean-Louis Dessalles, Maître de conférences en intelligence artificielle et sciences cognitives à Télécom Paris, « L’incapacité des systèmes d’IA actuels à repérer la singularité est lié au phénomène de la licorne. Un enfant repère immédiatement qu’une licorne ressemble à un cheval, mais qu’il y a une anomalie, une singularité. Un système d’IA est incapable de cette prouesse et verra dans une licorne, un cheval parfait. »

Il ne faut jamais oublier qu’une IA n’a pas de compréhension des informations qu’elle manipule. La « prédiction » ou la « décision » d’un algorithme n’est jamais que le résultat d’une suite de calculs. Ainsi, en l’absence de données épidémiologiques sur une zone géographique, une IA conclura que la zone n’a pas été touchée par l’épidémie, alors qu’un humain décidera plus rationnellement de ne pas la prendre en compte dans l’analyse. De la même façon, sans intelligence humaine, une IA ne « pensera pas » à prendre en considération la distanciation physique et le port du masque qui sont une habitude au Japon.

Un domaine de recherche immense

L’IA a certes permis la création d’applications utiles, comme le Covid-Bot mis en place par le gouvernement, mais elle n’a pas été une solution miracle pour anticiper l’ampleur de la pandémie, permettre d’identifier un remède efficace parmi les médicaments déjà présents sur le marché ou contribuer à la création d’un vaccin en un temps record.

Les défis sont encore nombreux à relever. Domaine encore très jeune et en plein essor, l’IA suscite un engouement important qui ne se dément pas chez les étudiants et les chercheurs et mobilise un grand nombre de disciplines.

Dans une tribune au Monde le 11 juin dernier, David Bounie, économiste, Winston Maxwell et Xavier Vamparys, juristes, tous trois chercheurs à Télécom Paris, préconisent notamment le développement d’IA hybrides, dans lesquels les modèles d’apprentissage statistique sont enrichis avec des bases de connaissances et des règles logiques issues de l’IA symbolique. Ils nous invitent à « […] repenser l’IA et à déterminer ce qui pourrait la rendre à l’avenir plus efficace et utile pour faire face à des situations analogues. Et avant de la revisiter, à mieux la comprendre. »

Technologie, transparence et acceptation sociétale : un cercle vertueux

La question de l’acceptation des intelligences artificielles reste, au-delà des aspects technologiques, un enjeu majeur pour leur efficacité. Plus une IA a accès à des informations en grand nombre et en temps réel, plus elle est efficace et pertinente. Or ces derniers mois les systèmes de surveillance automatique mis en place pour identifier, dans une foule, les personnes ayant de la température ou ne portant pas de masque ont suscité un émoi généralisé.

La collecte d’informations personnelles et la surveillance des individus réalisées de fait par ces dispositifs peuvent entraîner des manquements au RGPD, voire laisser craindre des atteintes aux libertés individuelles dans certains pays, comme l’a rappelé la Cnil dans son appel à la vigilance sur l’utilisation de ces caméras. A ce titre, la compréhension par les citoyens de ce que sont les IA, de leur fonctionnement et du rôle joué par les données, constitue un véritable enjeu de société.

Veiller, dès la conception des IA, à des systèmes transparents, explicables et éthiques, respectueux de la vie privée, est une obligation liée au « privacy by design » rappelée par la RGPD. C’est aussi une nécessité fondamentale pour que l’IA soit pleinement acceptée par la population et devienne fiable et utile. A Télécom Paris, ce cercle vertueux est largement encouragé par des initiatives de recherche transdisciplinaires comme Operational AI Ethics et par la diffusion de cette approche au sein même des cursus de formation des futurs ingénieurs en intelligence artificielle.

Mastères Spécialisés de Telecom Paris Accélérateurs de carrières numériques

Mastères Spécialisés de Telecom Paris Accélérateurs de carrières numériques